17.07.2020 11:00

Neuer Lernalgorithmus soll Einsatzmöglichkeiten von AI deutlich ausweiten

Die an der TU Graz entwickelte Lernmethode e-prop bildet die Grundlage für drastisch energieeffizientere Hardware-Implementierungen von Artificial Intelligence.

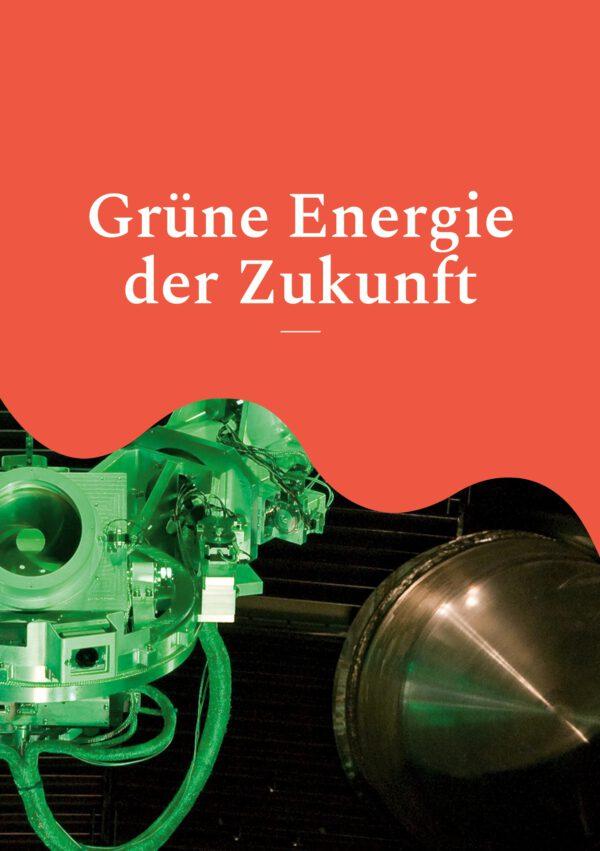

Der hohe Energieverbrauch beim Lernen von künstlichen neuronalen Netwerken ist eine der größten Hürden für den breiten Einsatz von Artificial Intelligence (AI), vor allem bei mobilen Anwendungen. Ein Ansatz, um dieses Problem zu lösen ist, von Erkenntnissen über das menschliche Gehirn zu lernen: Dieses hat zwar die Rechenleistung eines Supercomputers, braucht mit 20 Watt aber nur ein Millionstel von dessen Energie. Verantwortlich dafür ist unter anderem die effiziente Informationsweitergabe zwischen den Neuronen im Gehirn: Diese senden dazu kurze, elektrische Impulse (Spikes) an andere Neuronen – um Energie zu sparen aber nur so oft, wie unbedingt notwendig.

Ereignisbasierte Informationsverarbeitung

Diese Funktionsweise hat sich eine Arbeitsgruppe rund um die beiden TU Graz-Informatiker Wolfgang Maass und Robert Legenstein bei der Entwicklung des neuen maschinellen Lernalgorithmus e-prop (kurz für e-propagation) zu eigen gemacht: Die Forschenden des Instituts für Grundlagen der Informationsverarbeitung, die auch Teil des europäischen Leuchtturmprojekts Human Brain Project sind, nutzen in ihrem Modell Spikes zur Kommunikation zwischen Neuronen in einem künstlichen neuronalen Netz. Die Spikes werden nur dann aktiv, wenn sie für die Informationsverarbeitung im Netzwerk gebraucht werden. Das Lernen ist für solche wenig aktiven Netzwerke eine besondere Herausforderung, da es längere Beobachtungen braucht um zu ermitteln, welche Neuronenverbindungen die Netzwerkleistung verbessern.

Bisherige Methoden erzielten zu geringe Lernerfolge oder erforderten enormen Speicherplatz. E-prop löst nun dieses Problem mittels einer vom Gehirn abgeschauten dezentralen Methode, bei der jedes Neuron in einer sogenannten e-trace (eligibility trace; dt. Ereignisspur) dokumentiert, wann seine Verbindungen benutzt wurden. Die Methode ist ähnlich leistungsfähig wie die besten und aufwändigsten bekannten anderen Lernmethoden. Details dazu wurden nun im wissenschaftlichen Journal Nature Communications publiziert.

Online statt offline

Bei vielen der derzeit eingesetzten Maschine-Learning-Techniken werden alle Netzwerkaktivitäten zentral und offline gespeichert, um alle paar Schritte nachvollziehen zu können, wie die Verbindungen während der Berechnungen benutzt wurden. Dies erfordert aber einen ständigen Datentransfer zwischen dem Speicher und den Prozessoren, eine der Hauptursachen für den zu großen Energie-Verbrauch gegenwärtiger AI-Implementationen. e-prop hingegen funktioniert vollkommen online, und erfordert auch im realen Betrieb keinen separaten Speicher – das Lernen wird dadurch viel energieeffizienter.

Triebfeder für neuromorphe Hardware

Maass und Legenstein hoffen, dass e-prop die Entwicklung einer neuen Generation von mobilen lernfähigen Rechensystemen vorantreibt, die nicht mehr programmiert werden müssen, sondern nach dem Vorbild des menschlichen Gehirns lernen und sich dadurch an laufend neue Anforderungen anpassen. Das Ziel ist es, diese Rechensysteme nicht mehr energieintensiv ausschließlich über eine Cloud lernen zu lassen, sondern den größeren Teil der Lernfähigkeit effizient in mobile Hardware-Komponenten einzubauen und dadurch Energie zu sparen.

Erste Schritte, e-prop in die Anwendung zu bringen, wurden bereits gemacht: So arbeitet das Team der TU Graz gemeinsam mit der Advanced Processor Technologies Research Group (APT) der Universität Manchester im Human Brain Projekt daran e-prop in das dort entwickelte neuromorphe SpiNNaker-System einzubauen. Gleichzeitig arbeitet die TU Graz mit Forschenden des Halbleiterherstellers Intel daran, den Algorithmus in die nächsten Version von Intels neuromorphen Chip Loihi zu integrieren.

Diese Forschungsarbeit ist an der TU Graz in den Fields of Expertise „Human and Biotechnology“ und „Information, Communication & Computing“ verankert, zwei von fünf Stärkefeldern der TU Graz.

Wissenschaftliche Ansprechpartner:

TU Graz | Institute of Theoretical Computer Science

Wolfgang MAASS

Em.Univ.-Prof. Dipl.-Ing. Dr.rer.nat.

Tel.: +43 316 873 5822

0699 8845 3149

maass@igi.tugraz.at

Robert LEGENSTEIN

Univ.-Prof. Dipl.-Ing. Dr.techn.

Tel.: +43 316 873 5824

robert.legenstein@igi.tugraz.at

Originalpublikation:

A solution to the learning dilemma for recurrent networks of spiking neurons in Nature Communications

Guillaume Bellec, Franz Scherr, Anand Subramoney, Elias Hajek, Darjan Salaj, Robert Legenstein, Wolfgang Maass;

DOI: 10.1038/s41467-020-17236-y

Weitere Informationen:

https://www.tugraz.at/institutes/igi/home/ (TU Graz | Institute of Theoretical Computer Science)

https://www.tugraz.at/tu-graz/services/news-stories/planet-research/einzelansich… (Forschungsbeitrag: Unser Gehirn – der spannendste aller Computer)

Merkmale dieser Pressemitteilung:

Journalisten, Wissenschaftler

Biologie, Elektrotechnik, Energie, Informationstechnik

überregional

Forschungs- / Wissenstransfer, Forschungsergebnisse

Deutsch